Contenidos

- Se ha detectado un nuevo problema de cobertura del índice

- cómo solucionar el error de servidor (5xx) de la consola de búsqueda de google

- ver cobertura del índice desactivada

- search console ha identificado que su sitio está afectado por 1 problemas de cobertura

- problema de cobertura de google error del servidor (5xx)

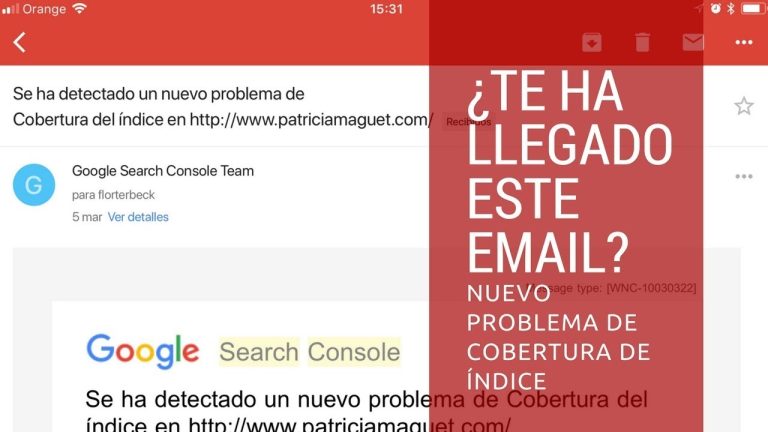

Se ha detectado un nuevo problema de cobertura del índice

cómo solucionar el error de servidor (5xx) de la consola de búsqueda de google

Si no eres la persona más técnica del mundo, es posible que algunos de los errores que te encuentres en la consola de búsqueda te dejen con la boca abierta. Hemos querido ponértelo un poco más fácil, así que hemos reunido esta práctica serie de consejos para guiarte por el camino. También exploraremos tanto los informes de Usabilidad Móvil como los de Core Web Vitals.

Recomiendo centrarse primero en la versión principal de su sitio web. Es decir, la versión que ves cuando intentas visitar tu sitio web en tu navegador. Sin embargo, en última instancia, querrás revisar todas las versiones.

Aquí es donde se puede hacer una inmersión en profundidad en todos los problemas técnicos que potencialmente están impidiendo que su sitio web de clasificación superior en los resultados de búsqueda. Hay cuatro tipos de problemas: Error, Válido con advertencias, Válido y Excluido.

La URL fue un error de redirección. Podría ser uno de los siguientes tipos: era una cadena de redirección demasiado larga; era un bucle de redirección; la URL de redirección superaba finalmente la longitud máxima de la URL; había una URL mala o vacía en la cadena de redirección.

ver cobertura del índice desactivada

Si utilizas un servicio de alojamiento de sitios como Wix o SquareSpace, es probable que tu servicio de alojamiento informe a Googe cada vez que publiques o actualices una página. Consulta la documentación de tu servicio de alojamiento para saber cómo publicar tus páginas y hacerlas localizables por los motores de búsqueda.

Lo ideal es que el número de páginas indexadas válidas aumente gradualmente a medida que el sitio crece. Si observa caídas o picos, consulte la sección de solución de problemas. La tabla de estados en la página de resumen está agrupada y ordenada por “estado + razón”.

Su objetivo es conseguir la versión canónica de cada página importante indexada. Cualquier página duplicada o alternativa debe ser etiquetada como “Excluida” en este informe. Las páginas duplicadas o alternativas tienen sustancialmente el mismo contenido que la página canónica. Tener una página marcada como duplicada o alternativa suele ser algo bueno; significa que hemos encontrado la página canónica y la hemos indexado. Puede encontrar la página canónica de cualquier URL ejecutando la herramienta de inspección de URL. Vea más razones por las que pueden faltar páginas.

El tiempo de vida de un problema se extiende desde la primera vez que se detectó cualquier instancia de ese problema en su sitio hasta 90 días después de que la última instancia se marcara como desaparecida de su sitio. Si pasan noventa días sin que se repita, el problema se elimina del historial de informes.

search console ha identificado que su sitio está afectado por 1 problemas de cobertura

Su dirección de correo electrónico no será publicada. Los campos obligatorios están marcados *ComentarioPuede utilizar estas etiquetas y atributos HTML: <a href=”” title=””> <abbr title=””> <acrónimo title=””> <b> <blockquote cite=””> <cite> <code> <del datetime=””> <em> <i> <q cite=””> <s> <strike> <strong> Nombre *

Su dirección de correo electrónico no se publicará. Los campos obligatorios están marcados *ComentarioPuede utilizar estas etiquetas y atributos HTML: <a href=”” title=””> <abbr title=””> <acrónimo title=””> <b> <blockquote cite=””> <cite> <code> <del datetime=””> <em> <i> <q cite=””> <s> <strike> <strong> Nombre *

problema de cobertura de google error del servidor (5xx)

Es muy común ver problemas de cobertura de índice en sitios web o blogs nuevos. Si has recibido un mensaje en tu Search Console que dice “Nuevo problema de cobertura de índice detectado para el sitio “tudominio” entonces hay un par de cosas que debes comprobar.

Como el mensaje dice “Indexado, aunque bloqueado por robots.txt”. Debe comprobar el archivo de robots y ver si su archivo de robots permite que el rastreador rastree e indexe el sitio web. Si ha especificado los motores de búsqueda en el archivo de robots, compruebe si ha desautorizado alguna URL que no deba desautorizar. La mayoría de la gente sigue la práctica de no permitir los códigos para que sea limpio para los rastreadores. Pero esta práctica puede dar problemas en la indexación del sitio web. Tome el ejemplo del archivo de robots en mi blog.

He desautorizado las extensiones pero el resto de las url’s están permitidas y no se añade ningún parámetro extra. Intenta ser más específico con el archivo robots y sólo utiliza disallow cuando sea necesario. Usar la etiqueta disallow innecesariamente crearía problemas en la indexación del sitio web.